La startup chinoise d'IA DeepSeek vient de publier officiellement son dernier modèle de langage à grande échelle (LLM), DeepSeek-V3-0324. Avec une capacité allant jusqu'à 641 Go, ce modèle a été annoncé sur la plateforme AI Hugging Face sans que beaucoup d'informations ne soient révélées, conformément au style secret sur les nouveaux produits que l'entreprise a toujours appliqué jusqu'à présent.

La particularité de ce modèle est la licence MIT, qui permet une utilisation gratuite à des fins commerciales. Les premiers résultats de référence montrent que DeepSeek-V3-0324 est capable de fonctionner sur des configurations matérielles courantes, telles que le Mac Studio d'Apple avec la puce M3 Ultra. Le scientifique en IA Awni Hannun a rapporté qu'il était possible d'atteindre des vitesses de traitement de plus de 20 jetons par seconde en utilisant cette configuration. Cette capacité à exécuter un modèle de langage volumineux sur du matériel standard sur site contraste fortement avec l’approche traditionnelle consistant à utiliser une infrastructure de centre de données massive pour prendre en charge des modèles d’IA avancés.

Selon les informations de DeepSeek, les premiers tests ont montré des améliorations significatives par rapport aux versions précédentes. Ce modèle a été rigoureusement testé par des parties prenantes internes et a démontré d'excellentes performances, surpassant même tous les autres modèles concurrents et battant le Claude Sonnet 3.5 d'Anthropic dans les tâches qui ne nécessitent pas de réflexion approfondie. Cependant, contrairement aux modèles de type Sonnet qui nécessitent un abonnement payant, DeepSeek-V3-0324 est entièrement gratuit à télécharger et à utiliser.

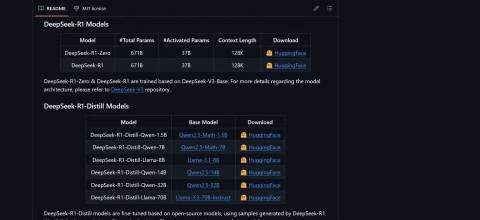

Techniquement, DeepSeek-V3-0324 utilise une architecture mixte d'experts (MoE). Il se distingue par sa capacité à utiliser de manière sélective environ 37 milliards des 685 milliards de paramètres par tâche, augmentant ainsi l'efficacité en réduisant les exigences de calcul tout en maintenant les performances. Ce modèle applique également les technologies Multi-Head Latent Attention (MLA) et Multi-Token Prediction (MTP), qui contribuent à améliorer la mémoire contextuelle et à accélérer la sortie.

Les utilisateurs peuvent accéder à DeepSeek-V3-0324 via Hugging Face, l'interface de chat et l'API d'OpenRouter, ainsi que la plate-forme de chat de DeepSeek s'ils le souhaitent. Le fournisseur de services d'inférence Hyperbolic Labs fournit également l'accès au modèle.

Avec la sortie de DeepSeek-V3-0324, la société continue d'affirmer sa position dans la course au développement de grands modèles de langage, tout en offrant une option puissante et accessible à la communauté de recherche et développement en IA. La possibilité de fonctionner sur du matériel standard associé à une licence gratuite ouvrira certainement de nombreuses possibilités d’application pratique pour ce modèle dans un avenir proche.