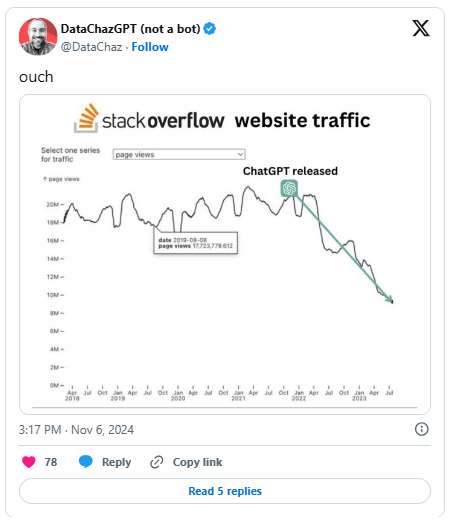

Selon le New Yorker, pour répondre aux 200 millions de demandes des utilisateurs, le chatbot ChatGPT d'OpenAI utilise plus d'un demi-million de kWh d'électricité chaque jour, soit 17 241 fois plus que la famille américaine moyenne (chaque famille utilise environ 29 kWh/jour).

C’est une chose inquiétante et nous devons nous préparer pour l’avenir, lorsque l’IA générative – l’intelligence artificielle – deviendra de plus en plus populaire et largement appliquée.

Une étude d'Alex de Vries, scientifique des données à la Banque nationale néerlandaise, a révélé que les nouveaux appareils d'IA consommeront autant d'électricité que les Pays-Bas ou des pays comme la Suède et l'Argentine d'ici 2027.

En supposant que Google intègre également l’IA générative dans chaque requête de recherche, la consommation d’électricité atteindrait environ 29 milliards de kWh par an, soit plus que la consommation totale de pays comme le Kenya, le Guatemala et la Croatie au cours de la même période.

Actuellement, il est difficile d’estimer la quantité d’électricité consommée par l’industrie de l’IA, car les modèles d’IA à grande échelle en cours d’exécution et les Big Tech ne divulguent pas avec précision leur consommation d’énergie.

Selon Alex de Vries, l’ensemble du secteur de l’IA consommera entre 85 et 134 TWh (1 térawatt = 1 milliard de kilowatts) par an d’ici 2027, soit environ la moitié de la consommation mondiale d’électricité.

Selon un rapport de Consumer Energy Solutions, les plus grandes entreprises technologiques du monde sont celles qui consomment le plus d’électricité au monde. Plus précisément, Samsung utilise près de 23 TWh, Google plus de 12 TWh et Microsoft environ plus de 10 TWh pour exploiter les centres de données, les réseaux et les appareils des utilisateurs.

À l’avenir, l’industrie de l’IA affectera grandement la sécurité énergétique et aura également des impacts négatifs indirects sur l’environnement s’il n’y a pas de plan ou de solution spécifique.