L'évolution de la technologie apporte des percées dans l'expérience visuelle mais aussi du graphisme à la vie, la nouvelle technologie Ray Tracing de nvidia est la réponse à ce développement lorsque la société lance la gamme de cartes graphiques .Graphiques de nouvelle génération basés sur leur architecture Turing. Alors, qu'est-ce que le Ray Tracing ? Pourquoi dire que c'est la technologie du futur ? Découvrons-le avec WebTech360 dans cet article

Qu'est-ce que le Ray Tracing ?

Le Ray Tracing est une technique de rendu (rendu) de la lumière en suivant les rayons lumineux (tracer signifie chasser, rayon signifie rayons lumineux). Vous pouvez imaginer cette technique comme la façon dont vous regardez le soleil, en suivant où ses rayons frappent, quels objets ils frappent et comment il brille sur les objets environnants. Le lancer de rayons recrée ce processus mais dans un environnement numérique.

En d'autres termes, le lancer de rayons suit la lumière absorbée, réfléchie, diffusée et diffusée par chaque objet dans l'environnement, et il s'applique non seulement à un faisceau de lumière du soleil mais à toute autre source lumineuse (par exemple : 2 ampoules dans la salle de jeu, le feu vacillant de la cheminée dans le jeu, la source de lumière artificielle est fixe lors du rendu 3D...).

Actuellement, l'architecture Turing avec Ray Tracing est toujours un gros point d'interrogation, on s'attend à ce qu'il soit un tournant révolutionnaire du marché des GPU, de tels produits sont susceptibles d'être vus dans la plupart des PC à l'avenir ou non, ou le prix est-il si élevé que peu de gens peuvent le posséder et l'utiliser ?

Difficile de répondre, car bien qu'il y ait eu des articles et des critiques pour les deux séries GeForce RTX 2080 FE et GeForce RTX 2080 Ti FE, il faut encore patienter, même pour les jeux qui supportent la haute technologie de la carte, voici ray tracé. De plus, les cartes graphiques professionnelles Quadro sont également équipées de cette nouvelle technologie : Quadro RXT 8000, Quadro RXT 6000, Quadro RXT 5000, Quadro RXT 4000.

Fonctionnement du lancer de rayons

L'objectif du lancer de rayons est de créer un éclairage plus réaliste et un ombrage plus naturel, et la série RTX de NVIDIA a obtenu des résultats impressionnants, du moins dans les démos de lancement. Une pièce en bois avec une fenêtre ouverte éclairera presque toute la pièce lors de l'utilisation d'un éclairage traditionnel, et lorsque le lancer de rayons est activé, les endroits à lumière directe seront plus lumineux que dans les coins sombres de la pièce. NVIDIA a également montré comment les flammes de Battlefield V peuvent hanter un personnage du jeu et brûler les portes des voitures de manière très réaliste.

La lumière n'affecte pas seulement l'éclairage, elle affecte également la couleur, la profondeur et les ombres. Ainsi, lorsque l'éclairage est simulé proche de la réalité, le reste des éléments est également bien fait. Les shaders du jeu actuel semblent assez durs et clairs, sans la légère transition entre les patchs clairs et sombres, et le lancer de rayons est la pièce qui rend cela possible.

Algorithme de lancer de rayons

Créer une simulation du monde réel est une entreprise très complexe. Il comprend de nombreux facteurs, comme un nombre infini de faisceaux lumineux, de surfaces réfléchissantes, traversant des objets, tous basés sur les propriétés moléculaires de chaque objet, sans parler de la gravité et des interactions physiques. Simuler une telle chose "infinie" en utilisant uniquement les ressources finies de l'ordinateur actuel est complètement disproportionné et impossible.

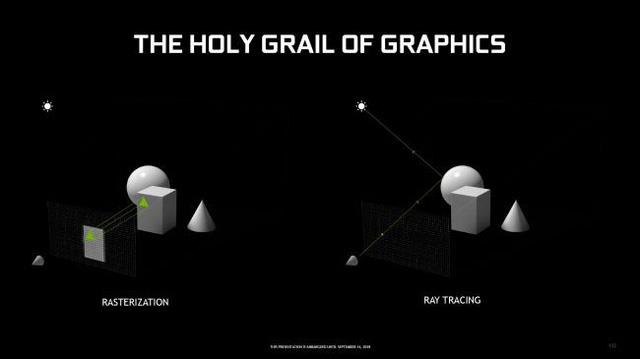

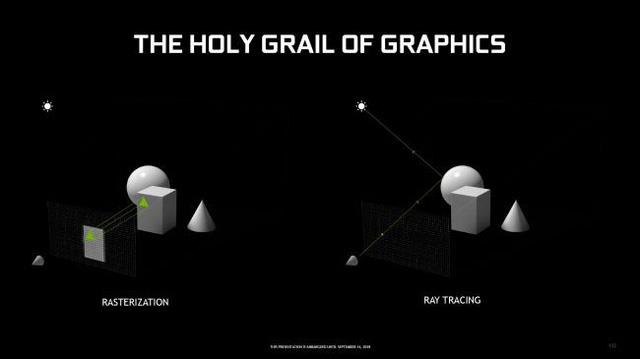

Nous appelons une solution au problème ci-dessus "rastérisation", au lieu de traiter un nombre infini de photons, le traitement commence par des polygones. Plus de polygones signifie une vitesse de traitement plus rapide, et la rastérisation est là pour transformer ces millions de polygones en une image spécifique.

En bref, il crée des prototypes 2D et les rend sur un monde 3D pré-construit. Dans celui-ci, les images 2D constituées de polygones peuvent couvrir tout l'écran lorsqu'elles sont vues de près, mais peuvent ne couvrir que quelques pixels lorsqu'elles sont vues de loin, créant ainsi des pixels, des textures et des principes de lumière. Bien sûr, une technique ne peut pas couvrir l'ensemble du travail.

Diverses techniques telles que le Z-buffer (un tampon secondaire qui suit la profondeur de chaque pixel) accélèrent le processus, créant un outil qui rend les millions de polygones générés visibles, triables et gérés aussi efficacement que possible. Cela peut nécessiter des millions, voire des milliards de calculs par image que seuls les GPU modernes avec des vitesses de traitement de téraflops peuvent gérer.

Le lancer de rayons aborde le problème ci-dessus différemment de la rastérisation , historiquement il existe depuis environ 50 ans maintenant. Turner Whitted travaille actuellement pour NVIDIA , esquissant par le passé comment calculer le suivi récursif, ce qui donne des visuels impressionnants, notamment des ombres, des reflets, etc. Bien sûr, cela va être beaucoup plus compliqué que la pixellisation.

Le lancer de rayons consiste à détecter la direction d'un rayon (généralement un rayon de lumière) lors de sa projection dans le monde 3D. Supposons que vous souhaitiez construire un objet, la première chose à faire est de déterminer les rayons lumineux qui suivent le polygone qui compose l'objet, puis de prendre en compte les sources de lumière possibles, les propriétés du polygone telles que le matériau, la surface plane ou courbe , en bref, ajouter ou soustraire des rayons lumineux.

Ce processus est ensuite répété pour toutes les autres sources de lumière, y compris la lumière réfléchie par les objets de la scène. Il est si complexe que de nombreuses formules sont nécessaires pour rendre le lancer de rayons possible, même pour les surfaces transparentes et semi-transparentes, par exemple le verre ou l'eau . Tout doit avoir une limite de réflexion artificielle, car même un rayon ne peut pas détecter tout le nombre infini de photons.

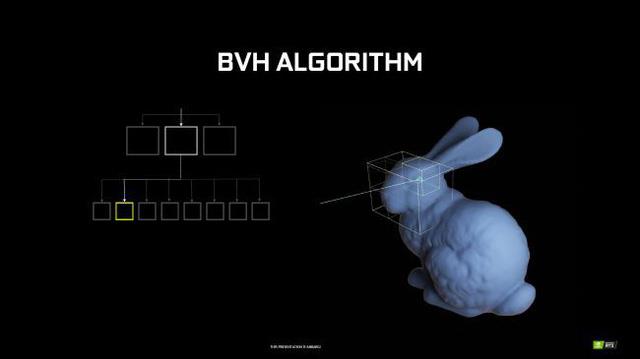

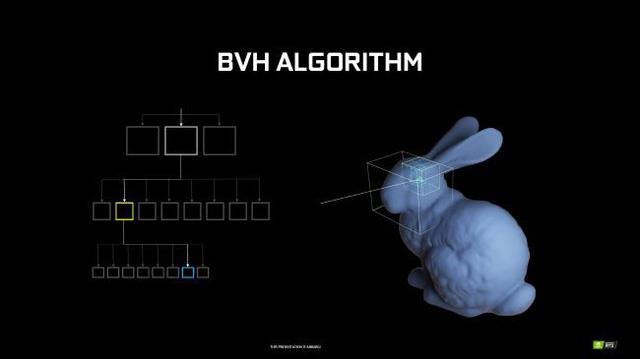

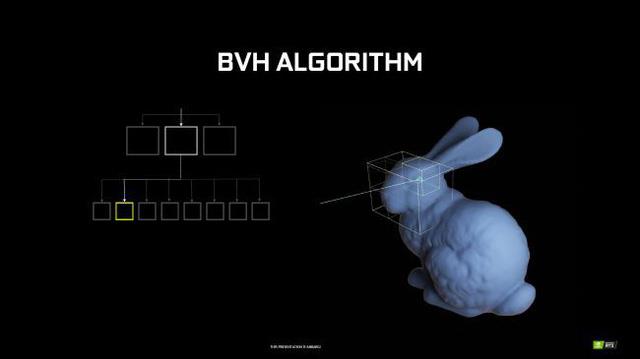

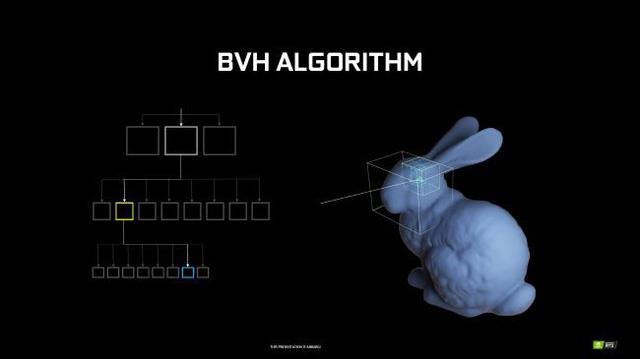

L'algorithme de ray tracing le plus couramment utilisé, selon NVIDIA , est BVH Traversal : Bounding Volume Hierarchy Traversal qui accélère le processus en zonant les objets à traiter, autrement dit "diviser pour mieux régner".

Vous pouvez vous référer au modèle de lapin de NVIDIA qui utilise l'algorithme BVH, qui localise chaque niveau, divise les parties en blocs, de plus en plus petits jusqu'à ce que l'algorithme aboutisse à une courte liste de polygones, puis le travail de lancer de rayons.

Cependant, la quantité de travail à effectuer lors de ce travail avec des logiciels sur le CPU ou le GPU est trop élevée. Une alternative est le noyau RT, chaque noyau RT a un algorithme de structure BVH intégré, ce qui le rend capable de traiter le travail 10 fois plus rapidement que le noyau CUDA.

De plus, il faut aussi mentionner combien de rayons lumineux sont détectés sur un pixel, un seul rayon entraîne des dizaines ou des centaines de calculs, mais plus il y a de rayons suivis, plus le travail sera léger, et la productivité sera élevée. Des entreprises comme Pixar utilisent également la technologie de lancer de rayons pour créer des animations.

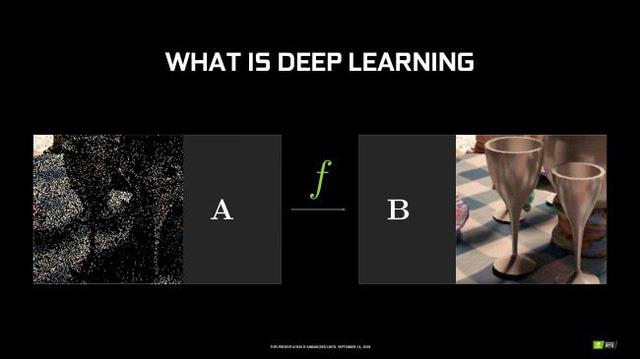

Un film de 90 minutes avec une fréquence d'images de 60 images par seconde nécessite 324 000 images, chacune prenant plusieurs heures à calculer les rayons qui suivent chaque pixel. Comment NVIDIA va-t-il parvenir à un tel équivalent temps réel ? J'ai mentionné l'apparition des cœurs RT ci-dessus, mais si cela ne suffit pas, la réponse est que les cœurs Tensor ne sont disponibles que dans l'architecture Turing. Pour un exemple simple, en prenant une charge de travail de FP16, les cœurs Tensor atteignent 114 TFLOPS tandis que FP32 et CUDA n'ont que 14,2 TFLOPS.

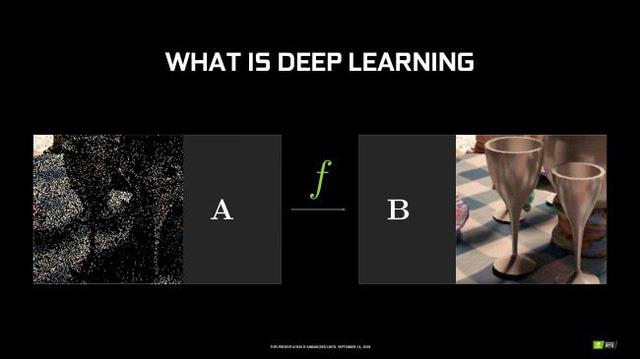

Mais pourquoi le noyau Tensor est-il suffisant pour le lancer de rayons ? C'est de l'IA et de l'auto-apprentissage, en d'autres termes c'est la fonction Deep Learning Super Sampling qui permet au jeu de rendre à une résolution inférieure sans AA, puis le noyau Tensor héritera et impactera le cadre, anti-aliasing pour une résolution plus élevée.

En conclusion, de grands noms de l'industrie du rendu se sont lancés dans le ray tracing comme Epic, UE, Unity 3D, EA Frostbite. Microsoft a même créé DirectX Ray spécifiquement pour le lancer de rayons. Avec RTX, c'est vraiment un grand saut dans l'industrie de l'infographie, bien sûr ce n'est toujours pas terminé et dans les dix prochaines années, être en mesure de mettre le RTX 2080 Ti sur le marché en tant que grand public est complètement peut-être.

Technologie Ray Tracing sur les dernières cartes graphiques de NVIDIA

La technologie graphique actuelle de NVIDIA et de pratiquement toute l'industrie consiste à simuler la lumière et le comportement de la lumière dans une scène donnée, d'une manière plus simple, appelée rastérisation. Comme un peintre peint, les objets sont rendus couche par couche, à l'envers, de sorte que les objets au premier plan masquent les objets à l'arrière-plan.

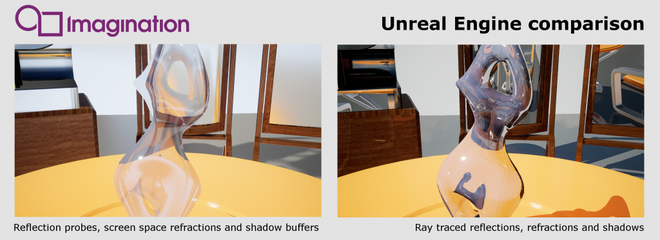

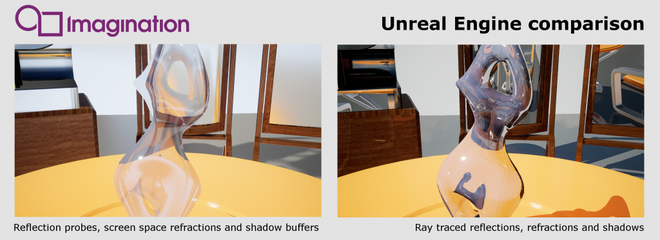

Différence d'affichage entre le raster conventionnel (à gauche) et le lancer de rayons (à droite).

Cependant, cette approche sera difficile lors du rendu de la réflexion, car la technique raster ne pourra pas suivre et restituer la lumière. Il est souvent utilisé dans les scènes en temps réel car le matériel actuel n'est pas suffisant pour simuler le mouvement de scènes complexes, par exemple dans les jeux vidéo ou les animations 3D.

Pendant ce temps, le lancer de rayons reconstruit le comportement de la lumière lorsqu'elle frappe des surfaces, des matériaux et des objets en mouvement.

La lumière qui traverse une scène peut être rendue et rendue plus complexe. Avec le lancer de rayons, vous pouvez simuler la façon dont les rayons lumineux interagissent avec les objets, créant des réflexions, des réfractions et des effets de diffusion réalistes en temps réel. Le lancer de rayons peut même détecter et afficher des réfracteurs, des réflecteurs, visualiser la source de lumière dans la scène et même la couleur de la lumière après qu'elle ait traversé le sujet.

En fait, cette technique a été utilisée dans la pratique, avec des films comme Pixar's Monsters University, Marvel's Iron Man. Mais c'était à l'époque où il était utilisé par des utilisateurs professionnels, mais maintenant il a été apporté aux utilisateurs généraux - quelque chose qui était impossible auparavant.

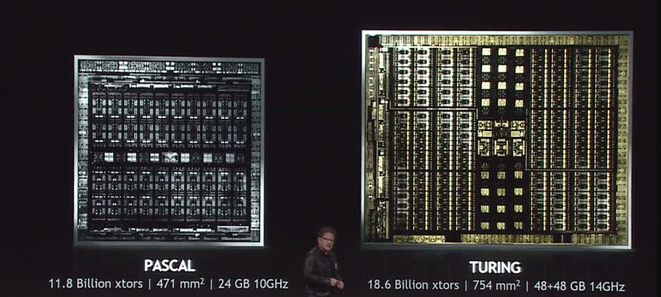

Cela mérite d'être qualifié d'exploit de NVIDIA car le ray tracing nécessite une énorme puissance de calcul. Le PDG de NVIDIA, Jensen Huang, a déclaré que c'était "le plus grand bond que nous ayons jamais fait en une génération (cartes GPU)".

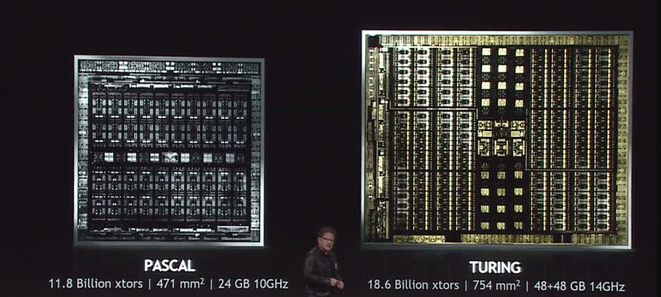

La façon dont NVIDIA résout le problème consiste à utiliser la nouvelle architecture Turing dans les nouveaux GPU. Cette architecture est conçue pour résoudre le problème de traitement. Les cœurs de traçage de rayons dédiés sont également équipés de Tensor Cores, qui sont capables d'utiliser l'IA pour déduire la partie "en temps réel" de l'image - le problème le plus intensif en calcul de cette technique. Ainsi, les GPU sont capables d'émuler 6 fois plus rapidement que la plate-forme Pascal précédente (sur GTX 1080Ti).

C'est vraiment un énorme bond en avant dans la technologie graphique et il est excitant de penser que les studios et les particuliers pourront désormais étendre l'utilisation de cette technique de lancer de rayons aux applications d'animation, de jeux scientifiques et de simulations.

Espérons que la technologie Ray Tracing sera de plus en plus développée, alors nous connaîtrons une qualité d'image encore plus belle, mais à l'heure actuelle, il vous est vraiment difficile d'expérimenter le Ray Tracing pour d'autres jeux terribles car ils nécessitent d'énormes logiciels. Si vous avez besoin de conseils sur la configuration du jeu Ray Tracing, veuillez contacter WebTech360 .

Synthétisé à partir de : Genk.vn