Meta lance Llama 4 : le LLM multimodal ultime

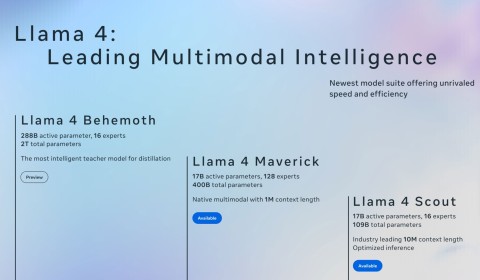

Cette série comprend trois versions : Llama 4 Scout, Llama 4 Maverick et Llama 4 Behemoth.

Début avril 2025, Meta a lancé Llama 4 , la dernière série de modèles d'IA conçus pour faire passer l'entreprise au niveau supérieur. Chaque nouveau modèle Llama 4 présente des améliorations significatives par rapport à ses prédécesseurs, et voici les nouvelles fonctionnalités remarquables à essayer.

3. Architecture mixte d'experts (MoE)

L’une des caractéristiques les plus remarquables des modèles Llama 4 est la nouvelle architecture MoE, une première pour la série Llama, qui utilise une approche différente des modèles précédents. Dans la nouvelle architecture, seule une petite fraction des paramètres du modèle est activée pour chaque jeton, contrairement aux modèles de transformateurs denses traditionnels comme Llama 3 et inférieurs, où tous les paramètres sont activés pour chaque tâche.

Par exemple, Llama 4 Maverick n'utilise que 17 milliards de paramètres actifs sur 400 milliards, avec 128 experts routés et un expert partagé. Llama 4 Scout, le plus petit de la série, possède un total de 109 milliards de paramètres, n'en activant que 17 milliards avec 16 experts.

La plus grande version du trio, Llama 4 Behemoth, utilise 288 milliards de paramètres actifs (avec 16 experts) sur un total de près de deux mille milliards de paramètres. Grâce à cette nouvelle architecture, seuls deux spécialistes sont affectés à chaque tâche.

Grâce au changement architectural, les modèles de la série Llama 4 sont plus efficaces en termes de calcul lors de la formation et de l'inférence. L'activation d'une petite partie seulement des paramètres réduit les coûts de service et la latence. Grâce à l'architecture MoE, Meta affirme que Llama peut fonctionner sur un seul GPU Nvidia H100, un exploit impressionnant compte tenu du nombre de paramètres. Bien qu'il n'existe pas de mesures spécifiques, on pense que chaque requête adressée à ChatGPT utilise plusieurs GPU Nvidia, ce qui crée une surcharge plus importante dans presque toutes les mesures mesurables.

2. Capacités de traitement multimodales natives

Une autre mise à jour importante des modèles d'IA de Llama 4 est le traitement multimodal natif, ce qui signifie que le trio peut comprendre du texte et des images simultanément.

Cela est possible grâce à la combinaison réalisée lors de la phase de formation initiale, où les jetons textuels et visuels sont intégrés dans une architecture unifiée. Les modèles sont formés à l’aide de grandes quantités de données de texte, d’image et de vidéo non étiquetées.

Ça ne peut pas être mieux que ça. Si vous vous en souvenez, la mise à niveau Llama 3.2 de Meta , sortie en septembre 2024, a introduit un certain nombre de nouveaux modèles (10 au total), dont 5 modèles de vision multimodale et 5 modèles de texte. Avec cette génération, l'entreprise n'a pas besoin de publier des modèles de texte et de vision séparés grâce aux capacités de traitement multimodal natives.

De plus, Llama 4 utilise un encodeur visuel amélioré, permettant aux modèles de gérer des tâches d'inférence visuelle complexes et des entrées multi-images, les rendant capables de gérer des applications qui nécessitent une compréhension avancée du texte et des images. Le traitement multimodal permet également d’utiliser les modèles LLama 4 dans une variété d’applications.

1. Fenêtre contextuelle de pointe

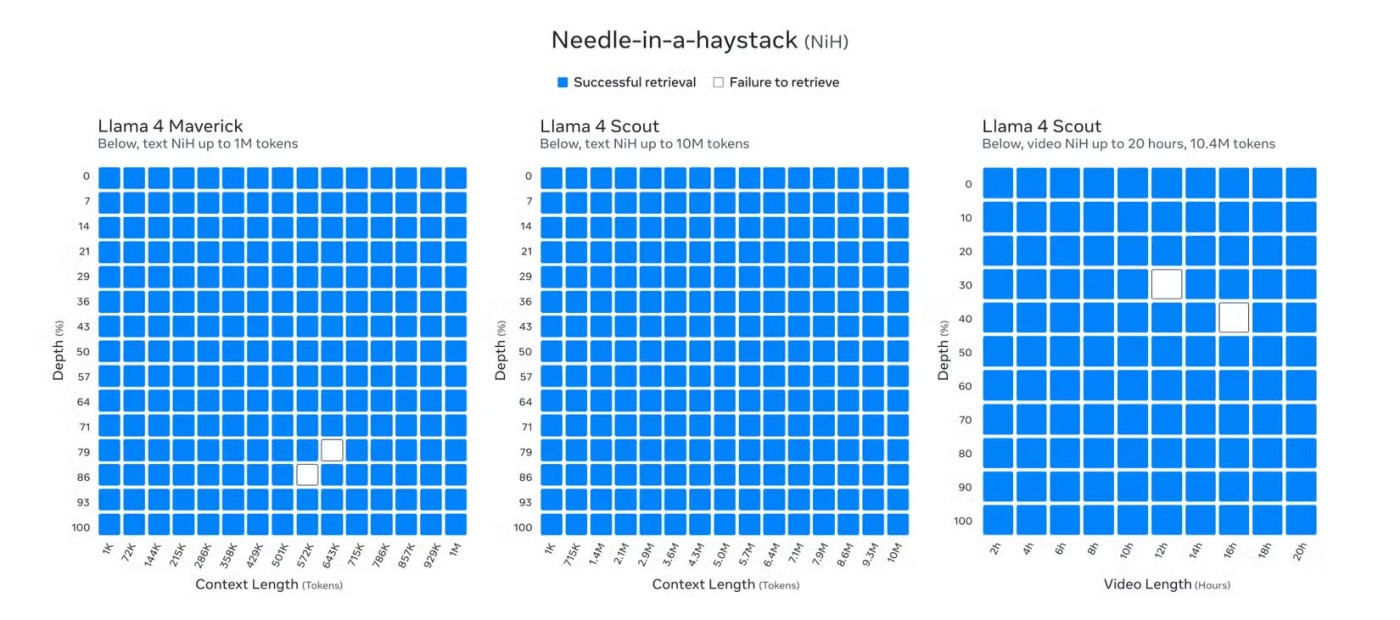

Les modèles d'IA de Llama 4 disposent d'une fenêtre contextuelle sans précédent pouvant atteindre 10 millions de jetons. Bien que Llama 4 Behemoth soit encore en développement au moment de la publication, Llama 4 Scout a établi une nouvelle référence dans l'industrie avec sa capacité à prendre en charge jusqu'à 10 millions de jetons en longueur de contexte, vous permettant de saisir du texte de plus de 5 millions de mots.

Cette longueur de contexte étendue représente une augmentation significative par rapport aux 8 000 jetons de Llama 3 lors de son premier lancement et même par rapport à l'extension ultérieure à 128 000 après la mise à niveau de Llama 3.2. Et ce n’est pas seulement la longueur de contexte de 10 millions du Llama 4 Scout qui est intéressante ; Même Llama 4 Maverick, avec sa longueur d'un million de contextes, est un exploit impressionnant.

Llama 3.2 est actuellement l’un des meilleurs chatbots IA pour les conversations prolongées. Cependant, la fenêtre de contexte étendue de Llama 4 place Llama en tête, surpassant la précédente fenêtre de contexte de 2 millions de jetons de Gemini, les 200 000 de Claude 3.7 Sonnet et les 128 000 de GPT-4.5.

Avec une grande fenêtre contextuelle, la série Llama 4 peut gérer des tâches qui nécessitent la saisie d'énormes quantités d'informations. Cette grande fenêtre est utile pour des tâches telles que l'analyse de documents longs et multiples, l'analyse détaillée de grandes bases de code et le raisonnement sur de grands ensembles de données.

Il permet également à Llama 4 de mener des conversations prolongées, contrairement aux modèles Llama précédents et aux modèles d'autres sociétés d'IA. Si l’une des raisons pour lesquelles Gemini 2.5 Pro est le meilleur modèle de raisonnement est sa grande fenêtre de contexte, vous pouvez imaginer à quel point une fenêtre de contexte 5x ou 10x est puissante.

Les modèles Llama de la série 3 de Meta font partie des meilleurs LLM du marché. Mais avec la sortie de la série Llama 4, Meta va encore plus loin en se concentrant non seulement sur l'amélioration des performances d'inférence (grâce à la nouvelle fenêtre de contexte à la pointe de l'industrie), mais également en garantissant les modèles les plus efficaces possibles en utilisant une nouvelle architecture MoE pendant la formation et l'inférence.

Les capacités de traitement multimodales natives de Llama 4, son architecture MoE efficace et sa grande fenêtre de contexte le positionnent comme un modèle d'IA ouvert, performant et flexible, pondéré en fonction du poids, capable de rivaliser ou de surpasser les principaux modèles d'inférence, d'encodage et de nombreuses autres tâches.

Vous rencontrez des problèmes avec le proxy dans Microsoft Teams ? Découvrez des solutions éprouvées pour résoudre ces erreurs. Videz le cache, ajustez les paramètres du proxy et retrouvez des appels fluides en quelques minutes grâce à notre guide expert.

Vous êtes frustré(e) car votre enregistrement Microsoft Teams a échoué ? Découvrez les principales causes, telles que les problèmes d’autorisation, les limites de stockage et les dysfonctionnements du réseau, ainsi que des solutions étape par étape pour éviter les échecs futurs et enregistrer parfaitement à chaque fois.

Vous êtes frustré(e) car les salles de sous-groupes sont introuvables dans vos réunions Teams ? Découvrez les principales raisons de leur absence et suivez nos solutions pas à pas pour les activer en quelques minutes. Idéal pour les organisateurs comme pour les participants !

Vous rencontrez des problèmes avec le Trousseau d'accès Microsoft Teams sur Mac ? Découvrez des solutions de dépannage éprouvées et détaillées pour macOS afin de retrouver une collaboration fluide. Des solutions rapides à l'intérieur !

Découvrez l'emplacement précis des clés de registre Microsoft Teams sous Windows 11. Ce guide pas à pas vous explique comment les trouver, y accéder et les modifier en toute sécurité pour optimiser les performances et résoudre les problèmes. Indispensable pour les professionnels de l'informatique et les utilisateurs de Teams.

Vous en avez assez de l'erreur 1200 de Microsoft Teams qui interrompt vos appels téléphoniques ? Découvrez des solutions rapides et simples pour iOS et Android afin de reprendre rapidement une collaboration fluide, sans aucune compétence technique requise !

Vous êtes frustré(e) par la disparition de l'icône Microsoft Teams dans Outlook ? Découvrez où la trouver, pourquoi elle disparaît et comment la faire réapparaître pour des réunions sans souci. Mise à jour pour les dernières versions !

Vous rencontrez des difficultés avec le chargement des onglets Wiki dans Microsoft Teams ? Découvrez des solutions éprouvées, étape par étape, pour résoudre rapidement le problème, restaurer vos onglets Wiki et optimiser la productivité de votre équipe en toute simplicité.

Vous en avez assez des plantages de Microsoft Teams avec erreur critique ? Découvrez la solution éprouvée de 2026 modifications du registre qui résout le problème en quelques minutes. Guide pas à pas, captures d'écran et astuces pour une solution définitive. Compatible avec les dernières versions !

Rejoignez facilement une réunion Microsoft Teams grâce à votre identifiant et votre code d'accès, que ce soit sur ordinateur, mobile ou navigateur web. Suivez les instructions étape par étape avec des captures d'écran pour un accès rapide : aucune invitation n'est requise !

Vous rencontrez des problèmes de lenteur avec Microsoft Teams ? Découvrez comment vider le cache de Microsoft Teams étape par étape pour résoudre les problèmes de performance, les ralentissements et les plantages, et améliorer la vitesse sur Windows, Mac, le Web et les appareils mobiles. Des solutions rapides et efficaces !

Vous rencontrez des problèmes de réseau avec Microsoft Teams sur un réseau Wi-Fi public ? Trouvez des solutions instantanées : optimisation du VPN, vérification des ports et vidage du cache pour rétablir vos appels et réunions sans interruption. Guide pas à pas pour une résolution rapide.

Découvrez où trouver le code QR Microsoft Teams pour une connexion mobile ultra-rapide. Un guide pas à pas illustré vous permettra de vous connecter en quelques secondes, sans mot de passe !

Vous en avez assez d'un son étouffé ou inexistant avec votre micro dans Microsoft Teams ? Découvrez comment résoudre les problèmes de micro de Microsoft Teams en quelques étapes simples et éprouvées. Un son clair vous attend !

Vous avez du mal à trouver le dossier d'installation de Microsoft Teams sur votre PC ? Ce guide pas à pas vous indique précisément où trouver les versions de Teams (nouvelle et classique), pour une installation par utilisateur ou par machine. Gagnez du temps !